半监督学习

半监督学习

E-mail: xin.lu@m.scnu.edu.cn

半监督学习是无监督和监督学习的一种折中,它能够同时利用标记样本和未标记样本进行学习。(监督、无监督→半监督)

一、充分利用未标记样本

在传统的监督学习中,学习器通过对大量有标记的(labeled)训练样本进行学习,从而建立模型用于预测测试样本的标记。

随着数据收集和存储技术的飞速发展,收集大量未标记的(unlabeled)样本已相当容易,而获取大量有标记的样本则相对较为困难,因为获得这些标记可能需要耗费大量的人力物力。例如在计算机辅助医学图像分析中,可以从医院获得大量的医学图像作为训练样本,但如果要求医学专家把这些图像中的病灶(即发生病变的部分)都标识出来,则往往是不现实的。因此,在有标记样本较少时,如何利用大量的未标记样本来改善学习性能已成为当前机器学习研究中最受关注的问题之一。

二、利用未标注样本的三类方法

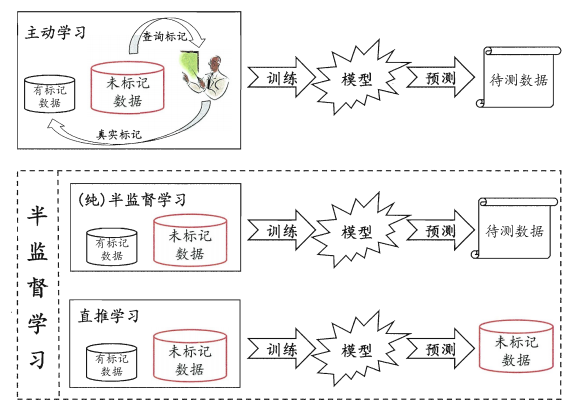

1、(纯)半监督学习(semi-supervised learning)

2、直推学习(transductive learning)

3、主动学习(active learning)。

这三类技术都是试图利用大量的未标记样本来辅助对少量有标记样本的学习,但它们的基本思想却有显著的不同。(主动 VS 半监督and直推;半监督VS直推;主动、直推的目的)

图 2-1 主动学习、(纯)半监督学习、直推学习

三、未标注样本如何提高学习性能

(为学习器补充了额外的知识)

通过合理建立未标记样本分布和学习目标之间的联系,就可以利用未标记样本来辅助提高学习性能。一般的情况下需要在某些假设的基础上来建立未标记样本和目标之间的联系。两种假设:

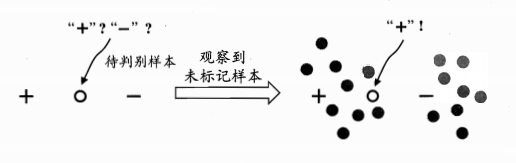

1、聚类假设

是指处在相同聚类(cluster)中的样本有较大的可能拥有相同的标记。

![]()

图 3-1 未标记样本效用的示例.右边的灰色点表示未标记样本

2、流形假设

是指处于一个很小的局部邻域内的样本具有相似的性质,因此,其标记也应该相似。这一假设反映了决策函数的局部平滑性。和聚类假设着眼整体特性不同,流形假设主要考虑模型的局部特性。

四、三大类半监督算法

1、生成式方法

该算法以生成式模型为分类器,将未标记样本属于每个类别的概率视为一组缺失参数,然后采用 EM算法(最大期望算法)来进行标记估计和模型参数估计。

2、图半监督学习

该算法是基于图正则化框架的半监督学习算法。

3、协同训练(co-training)算法

它们使用两个或多个学习器,在学习过程中,这些学习器挑选若干个置信度高的未标记示例进行相互标记,从而使得模型得以更新。

五、具体算法

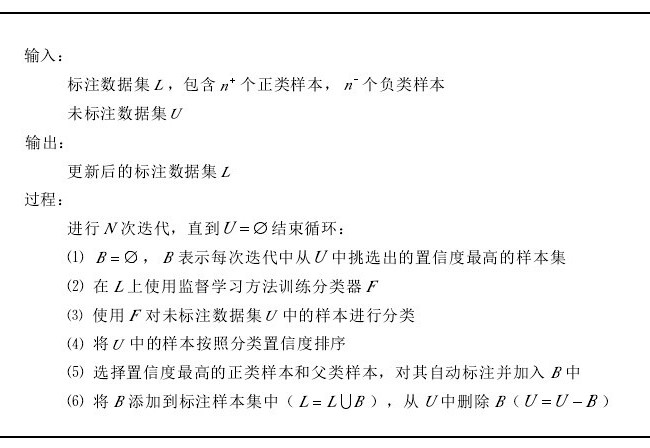

1、传统自训练算法

是一种基础且常见的半监督学习算法。算法流程:

图 5-1 传统自训练算法流程图

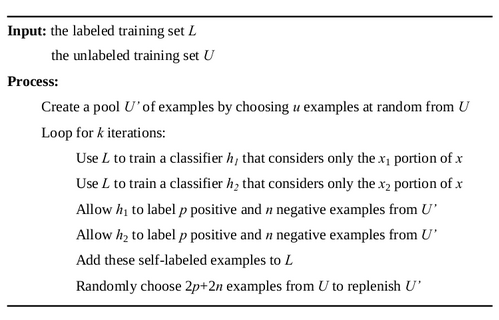

2、协同训练(co-training)算法

主要思想:假设数据集有两个充分冗余(sufficient and redundant)的视图(view),即两个满足下述条件的属性集:第一,每个属性集都足以描述该问题,也就是说,如果训练样本足够,在每个属性集上都足以学得一个强学习器;第二,在给定标记时,每个属性集都条件独立于另一个属性集。

例如,在一些网页分类问题上,既可以根据网页本身包含的信息来对网页进行正确分类,也可以利用链接到该网页的超链接所包含的信息来进行正确分类,这样的网页数据就有两个充分冗余视图,刻画网页本身包含的信息的属性集构成第一个视图,而刻画超链接所包含的信息的属性集构成第二个视图。(相互学习)

图 5-2 标准协同训练算法

六、参考文献:

[1]http://www.cnblogs.com/liqizhou/archive/2012/05/11/2496155.html 半监督学习

[2]http://www.cnblogs.com/liqizhou/archive/2012/05/11/2496162.html 协同训练算法

[3]周志华.机器学习.p293~p317

[4]高伟. 基于半监督集成学习的情感分类方法研究[D].苏州大学,2015.